Künstliche Intelligenz in der Informationssicherheit

Der Begriff künstliche Intelligenz (KI oder englisch Artifical Intelligence, AI) hat sich inzwischen etabliert, auch wenn die bestehenden Modelle von einer allgemeinen künstlichen Intelligenz (artifical general intelligence, AGI) noch weit entfernt sind. Modelle wie ChatGPT oder Claude werden und wurden beispielsweise eingesetzt, um Phishing Mails zu schreiben und Werkzeuge wie Copilot können genutzt werden, um Schadcode zu programmieren. Gleichzeitig wird praktisch jede Informationssicherheitssoftware, von der Firewall bis zur Endpoint Security mit integrierter KI beworben. Künstliche Intelligenz hat deshalb direkte Auswirkungen auf die Informationssicherheit.

KI in offensiver IT-Sicherheit

Künstliche Intelligenz in offensiver IT-Sicherheit, d.h. von Angreifern genutzt, beschränkt sich in den meisten Fällen noch auf Social Engineering, d.h. von einem Large Language Model (LLM) geschriebenen Text, der insbesondere auch in Fremdsprachen grammatikalisch korrekt erzeugt wird.

Social Engineering

Die Fähigkeit von generativen KI-Systemen, individuelle Kommunikationsstile zu analysieren und zu reproduzieren, führt inzwischen jedoch auch zu überzeugenden sogenannten Deepfake-Angriffen mit Video und Ton, wobei der Aufwand für überzeugende Fälschungen teilweise noch recht hoch ist, oder einfacheren Voice-Swapping Angriffen, bei denen vorhandenes Videomaterial nur mit neuem Ton versehen wird. Die verfügbaren Werkzeuge werden gleichzeitig schnell besser und günstiger.

Eine weitere Stärke von generativen KIs und LLMs ist die Fähigkeit, aus nur teilweise vorhandenen Informationen vollständige Passphrases zu erraten, also insbesondere die Sicherheit langer Passwörter und Passwort-Sätze zu schwächen.

Penetrationstests

Automatisierte Systeme sind insbesondere durch Machine Learning (ML) jedoch auch in der Lage, Systeme effizient nach Schwachstellen zu durchsuchen, eine fortgeschrittene Art des Fuzzings mit automatischer Anpassung und können für gefundene Schwachstellen inzwischen auch Exploits erzeugen. Andere Systeme wie DeepExploit lernen selbständig durch Reinforced Learning die Anwendung von Metasploit-Exploits und können Penetrationstests inklusive Berichtserstellung fast vollständig automatisiert durchführen.

Speziell im Bereich der automatisierten Penetrationstests in Verbindung mit verschiedenen Machine Learning Verfahren und großen Testmodellen die z.B. von Online Hacking-Plattformen bereitgestellt werden können, sind in naher Zeit deutliche Fortschritte zu erwarten.

KI in defensiver IT-Sicherheit

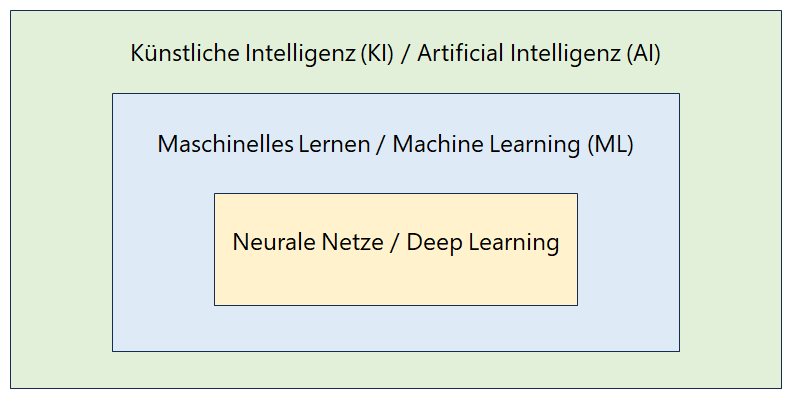

Praktisch alle Informationssicherheitssysteme werden aus Marketinggründen heute mit KI oder AI beworben. In der Praxis handelt es sich jedoch fast immer um Verfahren die auf Big Data und Machine Learning basieren und die zur Mustererkennung genutzt werden und nicht um generative oder sogar allgemeine künstliche Intelligenz.

Technische Informationssicherheit

Auf Firewalls und Intrusion Detection Systemen kann eine KI auftretende Anomalien im Datenverkehr frühzeitig erkennen und schneller reagieren, als ein menschlicher Administrator. Endpoint Security Systeme können abweichendes Nutzungsverhalten identifizieren und so legitime Nutzer von Angreifern unterscheiden, die Zugangsdaten gekapert und sich Zugang zum System verschafft haben.

Im Security Operations Center (SOC) wird KI insbesondere genutzt, um für den SOC-Analysten eine Vorauswahl zu treffen, um die Zeit des menschlichen Analysten optimal einzusetzen. Speziell für die Risikoanalyse und Triage sind KI-Systeme nützlich und können die Reaktionszeit deutlich beschleunigen.

Ein grundsätzliches Risiko der eingesetzten Machine Learning Verfahren ist jedoch, dass diese Verfahren eine Alpha-stabile Verteilung (stable distribution) für eine zuverlässige Erkennung benötigen. Diese Wahrscheinlichkeitsverteilung ist bei einem adaptiven Angreifer, der sein Verhalten anpassen kann, jedoch nicht mehr zuverlässig gegeben.

Überzeugende Honeypots

Da generative KI-Systeme on the Fly neue Informationen erzeugen aber grundsätzlich auch gespeicherte Informationen realistisch wiedergeben können, eignen sich LLMs beispielsweise gut für hoch-interaktive Honeypots, die dem Angreifer ein echtes System vorgaukeln können. Insbesondere kann ein LLM auch echt aussehende aber falsche vertrauliche Dokumente oder E-Mail-Ordner für den Angreifer erzeugen. Auch bereits vom Angreifer kopierte echte Daten können an Wert verlieren, wenn der Angreifer zwischen echten und falschen Daten nicht mehr unterscheiden kann.

KI als mögliches Sicherheitsrisiko

Systeme mit künstlicher Intelligenz werden jedoch nicht nur offensiv und defensiv genutzt, sondern können für sich selbst bereits ein mögliches Sicherheitsrisiko darstellen.

Halluzination von LLM

Large Language Modelle wie ChatGPT von OpenAI, Claude von Anthropic oder Gemini von Google sind in erster Linie generative KI-Systeme, die nach einem Wahrscheinlichkeitsverfahren ermitteln, welche Folge von Wörtern oder welche Ansammlung an Bildpunkten am besten zu einer Anfrage passen könnte. LLMs sind deshalb sehr gut darin, annähernd richtige oder zumindest plausible Antworten auf vage Fragen zu finden, oder unstrukturierte Daten annähernd richtig zu strukturieren und zusammenzufassen.

Ein grundsätzliches Problem aller LLMs ist jedoch, dass der KI jedes Verständnis der ausgegebenen Daten fehlt. Insbesondere findet keine Prüfung auf Logik bzw. Korrektheit statt. Fehler in den nur annähernd richtigen oder nur plausiblen aber tatsächlich falschen Informationen werden nicht erkannt. Dieses fehlende Verständnis von richtig bzw. wahr führt außerdem dazu, dass alle LLMs eine gewisse Neigung haben, nicht existente Inhalte zu „halluzinieren“, d.h. scheinbar echt klingende Inhalte zu erfinden und diese als Fakten zu präsentieren.

Mitarbeiter die LLMs nutzen, müssen deshalb speziell über die möglichen Fehler des Modells und über Risiken bei der Verwendung der generierten Antworten informiert werden. Besonders die richtige und kluge Auswahl der Prompts ist extrem wichtig und muss gelernt werden.

Data Leakage durch gelernte Daten

Gelernte Daten werden durch das Training der KI in das Wahrscheinlichkeitsmodell der LLM übernommen. Durch gezielte Anfragen an das LLM kann jedoch erreicht werden, dass im Training verwendete vertrauliche bzw. personenbezogene Daten wörtlich wiedergegeben werden. Dieses Verhalten wird als „Prompt Leakage“ bezeichnet und kann für Angriffe genutzt werden.

Verschiedene Unternehmen haben die Nutzung generativer KI-Systeme deshalb eingeschränkt oder verbieten die Nutzung mit vertraulichen oder personenbezogenen Daten.

Risiken durch limitierte Ressourcen

Ein LLM ist technisch gesehen ein sogenannter Transformer, der den gelernten Input, d.h. die Trainingsdaten, in eine neue Ausgabe transformiert. Dabei wird von Seiten des Betreibers des Modells aus Kostengründen ein Berechnungsbudget festgelegt, d.h. wie viel Rechenzeit verbraucht werden darf und bis zu welcher Berechnungstiefe gerechnet werden darf, bevor ein neues Token, z.B. ein neues Ausgabewort erzeugt wurde. Mit einem geringeren Berechnungsbudget erzeugt das LLM einfachere Antworten oder kann komplexe Prompts gar nicht richtig beantworten, mit einem höheren Budget können auch sehr komplexe Anfragen bearbeitet werden.

Unsere Leistung

Wir helfen Ihnen bei der sicheren Einführung generativer KI-Systeme in Ihrer Organisation. Wir bewerten Ihre KI-Systeme auf potentielle Risiken und stellen Ihnen Empfehlungen zur sicheren Nutzung zusammen.

Wir zeigen Ihnen, wie Sie künstliche Intelligenz sowohl offensiv als auch defensiv zur Verbesserung der Informationssicherheit einsetzen können.